Im dritten Teil unserer Serie "Datenmanagement als Erfolgsfaktor im Machine Learning" wird unter anderem der Weg vom Machine Learning zum Deep Learning und die Entwicklung vom Generative Adversarial Network (GAN) hin zu Deep Fakes aufgezeigt.

Gastbeitrag von Christoph Schnidrig, Leiter Systems Engineering Team, Netapp Schweiz

Vom Machine Learning zum Deep Learning

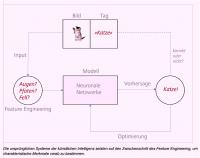

In der Anfangsphase arbeiteten AI-Systeme mit einer vorgeschalteten Merkmalerkennung, dem sogenannten Feature Engineering. Bestand die Aufgabe darin, ein Gesicht zu erkennen, so suchte das System zunächst nach den unverzichtbaren Merkmalen wie Augen, Nase oder Mund.

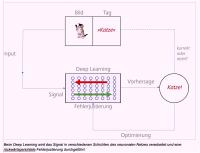

Beim Deep Learning (DL) besteht das neuronale Netz aus verschiedenen Schichten (Layers) mit künstlichen Neuronen. Vom Input zum Output durchläuft eine Anfrage in jedem Layer meistens eine ganz einfache Operation, zum Beispiel die Anwendung eines Filters. Die Neuronen identifizieren dabei möglicherweise Bildmerkmale, wie das früher beim Feature Engineering angestrebt wurde. Allerdings bleibt das Modell weitgehend sich selbst überlassen. Es kann also selbstständig entscheiden, welche Art von Elementen es am besten analysiert oder extrahiert, um den Inhalt des Bilds möglichst gut vorhersagen zu können. Der Vorteil ist, dass heute niemand mehr ein Feature Engineering für Papageien entwickeln muss, wenn Millionen von Papageienfotos zur Verfügung stehen. Die Schichten geben den neuronalen Netzen eine grössere Tiefe, woraus der Begriff Deep Learning entstand. Forscher auf dem Gebiet AI/ML entwickeln laufend neue Layers, während Entwickler neue Anordnungen der Layers testen, um die Ergebnisse zu verbessern.

Von Generative Adversarial Network (GAN) zu Deep Fakes

Zwei künstliche neuronale Netze können auch miteinander verknüpft werden, um die Bewertungsmethode eines der beiden Modelle zu verbessern. In einem solchen Generative Adversarial Network (GAN) erstellt ein Netzwerk (der Generator) Beispiele nach einem generativen Modell, während das zweite neuronale Netz (der Diskriminator) die Kandidaten nach einem diskriminierenden Modell bewertet. Obwohl es sich um ein Nullsummenspiel handelt, lernt das zweite Netzwerk, als „schlecht“ definierte Ergebnisse zu vermeiden. Gleichzeitig versucht das erste Netzwerk, das zweite zu einer schlechten Antwort zu bringen. Mit jedem negativen Resultat des Diskriminators wird der Generator ermutigt, bessere Beispiele zu liefern. Die Entwickler speisen dann zwischendurch echte Bilder mit bekannter Klassifikation ein, um die Qualität der Entscheidungen des Diskriminators zu prüfen. Der Diskriminator braucht diese Beispiele für sein Training – dank ihrer bleibt er auf Kurs und kann dem Generator sinnvolles Feedback geben. Die ersten GAN hatten zum Beispiel noch Bilder von Blüten generiert, denen die Blätter fehlten. Inzwischen werden GAN zur Erstellung fotorealistischer Bilder wie auch zur Modellierung von Bewegungsmustern in Videos, zur Erstellung von 3D-Modellen von Objekten aus 2D-Bildern oder zur Bildbearbeitung astronomischer Aufnahmen verwendet. Auch bei Facebook werden GAN beim unüberwachten Lernen zur Optimierung der Systeme eingesetzt. (1)

Was abstrakt mathematisch und abgehoben klingt, wird nachhaltige Konsequenzen für unseren zukünftigen Alltag haben. Im Prinzip lernt hier nämlich ein Netzwerk, etwas so gut wie möglich zu fälschen, während das andere die Fälschung zu erkennen versucht. Bringt man die beiden zusammen, entstehen am Ende Fälschungen, die so gut sind, dass man sie nicht mehr von Echtem unterscheiden kann. Das sind die sogenannten Deep Fakes: zum Beispiel die bekannten Videos von Barack Obamas Reden, die er in Wirklichkeit nie hielt. (2) Obama bewegt seine Lippen und eine Audiodatei liefert seine Stimme, jedoch mit Aussagen, die er nie machte.

Deep Fakes sind erst durch GAN möglich geworden und von fundamentaler Bedeutung für die Entwicklung von Deep Learning. Sie sind auch ein gutes Beispiel dafür, dass praktisch alles, was Entwickler im maschinellen Lernen anfassen, zum Erfolg führt. Die Chance, dass etwas gar nicht klappt, ist sehr gering. Und häufig ist der Entwicklungsaufwand sogar recht bescheiden, der Rechenaufwand unter Umständen aber immens. Deep Fakes sind ein gutes Beispiel dafür: Die mit einem Desktop erzielte Qualität ist auch nach Wochen noch enttäuschend. Im Vergleich zu anderen mathematischen Modellen, zum Beispiel der Finite-Elemente-Methode, sind ML-Modelle kleine Projekte. Deep-Fake-Videos lassen sich seit Januar 2018 sogar mit der Gratis-Software Fakeapp 2.2 (3) auf jedem beliebigen Desktop-Computer generieren. (4)

Zukünftige Anwendungen: Wenn der Browser einen Arztbesuch empfiehlt

Der Leiter des weltweiten Netzwerks der Microsoft-Forschungslabore, Eric Horvitz, zählt einerseits zu den Pionieren des maschinellen Lernens und hat andererseits einen Doktorgrad der Medizin. Seit Jahrzehnten arbeitet er daran, medizinische Diagnosen und Entscheidungsanalysen zusammenzubringen. Den AI-Winter überstand er durch eine Fokussierung auf konventionelle Bayes’sche Statistik. Seit maschinelles Lernen wieder en vogue ist, hat sein Team Hunderte Millionen Daten der Suchmaschine Bing analysiert. Horvitz’ Idee war, Personen mit Verdacht auf Bauchspeicheldrüsenkrebs anhand ihrer Browserchronik ausfindig zu machen. Zunächst sollten Bing-Nutzer ermittelt werden, deren Suchverhalten nahelegt, dass bei ihnen vor kurzem eine solche Krankheit diagnostiziert wurde – zum Beispiel weil sie „Bauchspeicheldrüsenkrebs“ und „Lebenserwartung“ ins Suchfeld eingaben. Diese Daten wurden mit IP-Adressen und anderen geografischen Angaben abgeglichen. Im nächsten Schritt suchten die Forscher in der vorausgegangenen Bing-Chronik derselben Benutzer nach Suchbegriffen wie „gelbe Haut“ oder „merkwürdiger Stuhlgang“, die auf typische Symptome hinweisen, anhand deren eine Diagnose möglicherweise zu einem früheren Zeitpunkt hätte gestellt werden können. Dank maschinellem Lernen lässt sich also aus den Suchbegriffen eines Benutzers herauslesen, ob bei ihm eine Krebserkrankung wahrscheinlich ist – und es kann ihm dementsprechend ein Arztbesuch empfohlen werden. Bei 5 bis 15 Prozent der identifizierten Verdachtsfälle war die Diagnose korrekt. Horvitz und sein Team gingen noch einen Schritt weiter und untersuchten die Mausbewegungen von insgesamt 31 Millionen Suchanfragen auf Bing in einem Zeitraum von 18 Monaten. Sie vermuteten, dass sich aus der Bewegung der Maus Anzeichen für eine Parkinson-Erkrankung ableiten lassen könnten. Im April 2018 publizierten die Forscher ihre Ergebnisse. (5) Die Diagnose Parkinson hätten sie auch ohne Berücksichtigung der Mausbewegungen, allein aufgrund der Suchbegriffe, vermuten können – aber mit den Mausbewegungen war das Ergebnis genauer.

Grafikprozessoren bringen maschinelles Lernen auf den Desktop

Mitarbeiter der auf die Produktion von Grafikprozessoren (Graphics Processing Unit, kurz GPU) spezialisierten Firma Nvidia waren 2009 an dem sogenannten Big Bang des Deep Learning beteiligt. Sie kombinierten neuronale Netze mit den für ihre besonders schnelle Rechenleistung bekannten GPU. Andrew Ng, der Gründer von Google Brain, dem Deep-Learning-Forschungszentrum von Google, prognostizierte, dass Kalkulationen durch den Einsatz von GPU um den Faktor hundert beschleunigt werden könnten. Im Dezember 2016 lieferte Nvidia dann mit dem DGX-1 den weltweit ersten kompakten Supercomputer aus, der eine Rechenleistung von 170 teraFLOPS bot. Mit der im März 2018 vorgestellten DGX-2 wuchs die Leistung noch einmal um mehr als das Zehnfache auf 2 Petaflops. Für rund 400'000 US-Dollar ersetzt die DGX-2 rund 800 herkömmliche Server und ermöglicht Deep-Learning-Modellberechnungen. Solche kompakten Systeme sind besonders dann von Vorteil, wenn die Daten so vertraulich sind, dass sie das Gebäude nicht verlassen dürfen. Die meisten im Deep Learning engagierten Entwickler arbeiten allerdings zurzeit mit Systemen, bei denen mehrere hundert oder tausend Server im Rechenzentrum eines Hyperscalers parallelgeschaltet werden. Die Kalkulationen sind dabei so aufwendig, dass die Systeme Stunden, Tage oder sogar Wochen mit einem Training ausgelastet sind. Die grosse Nachfrage nach solchen IT-Infrastrukturen durch externe Kunden ist weitgehend für den aktuellen Boom im Rechenzentrums-Markt verantwortlich.

Wissenschaftliche Veröffentlichungen enthalten immer auch Angaben zur Rechenzeit, die für ein Deep-Learning-Modell erforderlich war. Denn Rechenzeit bedeutet Geld. Für die bekannten DL-Modelle gibt es Benchmarks, unter denen Dawnbench als führend gilt.

Solche Benchmarks zeigen für die wichtigsten Modelle, welche Hardware die schnellsten Berechnungen verspricht und wie teuer die Kalkulationen zu stehen kommen. Die Hyperscaler bieten eigene AI-Software, sogenannte Frameworks, an. Dazu zählen Caffe, Theano, Tensor Flow (Google) und CNTK (Microsoft Cognitive Toolkit). Daneben stellen sie auch Hardware-Plattformen (AWS, Azure, Google Cloud Platform) zur Verfügung. Neben den grossen Cloud-Anbietern verfügen am ehesten noch Banken und Versicherungen über Rechenzentren, in denen solche Modelle angewendet werden können.

Fussnoten:

(1) https://www.scientificamerican.com/article/when-will-computers-have-comm...

(2) https://www.youtube.com/watch?v=AmUC4m6w1wo

(3) www.fakeapp.org

(4) https://www.youtube.com/watch?v=7XchCsYtYMQ

(5) https://neuroscience.stanford.edu/news/your-computer-may-know-you-have-p...

Zu Teil 1 der Serie hier!!

Zu Teil 2 der Serie hier!!

Zu Teil 4 der Serie hier!!